私有化部署DeepSeek要了解的3个认知!安装小模型如何不“翻车”?

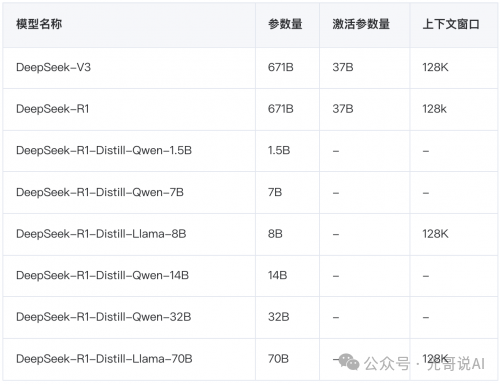

部署DeepSeek-R1(671B)纯血模型官方推荐配置中,仅显存至少要1.5TB,如果按NVIDIA H100 80GB显卡来算,需要近20卡,还要根据MoE模型并行策略进行集群配置,这不算对CPU、存储、网络等要求,这是有一定的技术门槛和资金门槛的。一般情况下,个人或中小企业根本无法承受这个成本的。

因此,个人或小企业部署一般选择DeepSeek-R1-Distill-XXXX中的某一款蒸馏模型,这也是大家看到的文章或视频中所部署的。实际上,它们在能力和表现上往往远不及那些拥有数百亿甚至数千亿参数的大型模型。为什么呢?它们之间的推理能力差异,其核心原因涉及模型架构、训练范式、参数规模和硬件适配等多维度的技术差异。你需要了解以下常识:

关键认知2:蒸馏模型与基座模型的本质区别

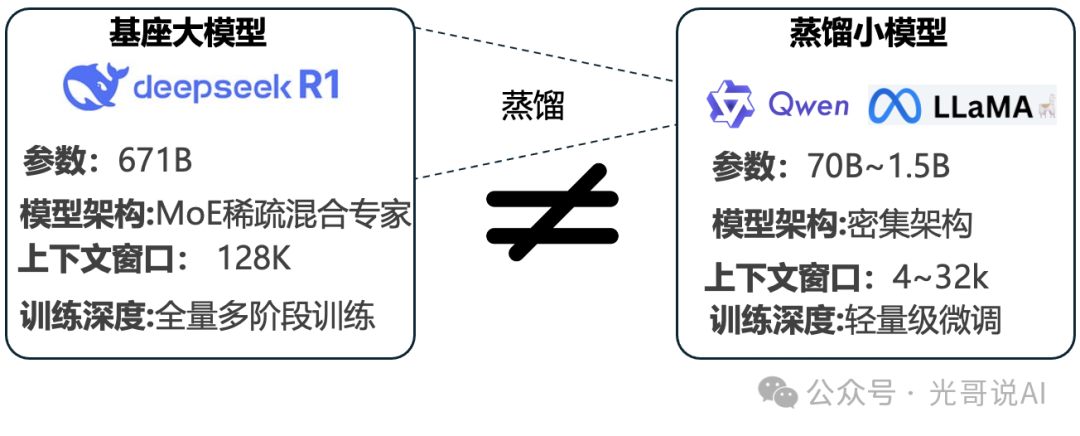

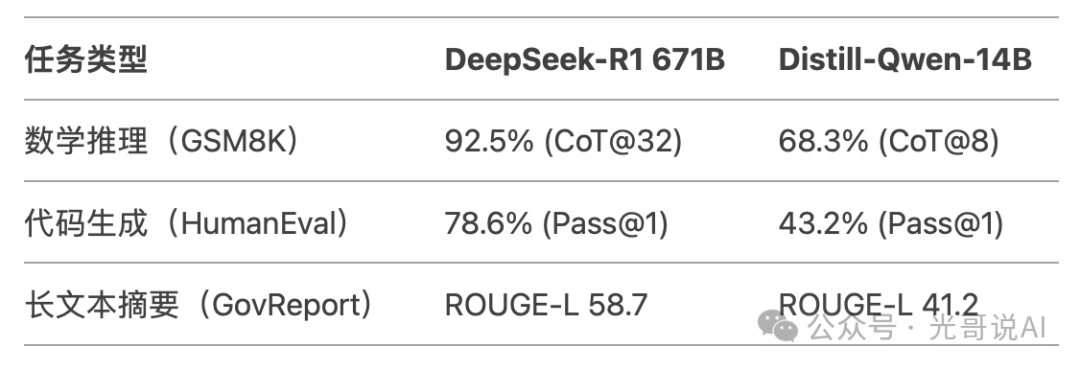

蒸馏模型(如DeepSeek-R1-Distill-Qwen-7B)是通过知识蒸馏技术,将基座大模型(如DeepSeek-R1 671B)的知识迁移至更小、更轻量的架构中。其核心是通过让大模型(教师模型)指导小模型(学生模型)模仿其输出分布或中间特征,从而在保留部分能力的前提下大幅降低参数量和计算成本。但受限于规模,蒸馏模型无法完全复现大模型的复杂推理能力、长程上下文理解及泛化性,尤其在需要多步逻辑、领域专业知识或高精度生成的任务中表现显著弱于基座模型。

两者不是简单的“师生关系”,而是“专家委员会 vs 全科医生”的本质区别。教师模型(MoE) 就像一支由128位领域专家(数学、编程、医学等)组成的委员会,遇到问题时自动选择最相关的2-4位专家共同解答。 学生模型(密集架构) 则像一位全科医生,必须独自掌握所有知识——尽管通过“学习”记住了专家们的答案套路,但面对复杂问题(如同时涉及代码和数学推导)时,因缺乏真正的专家协作机制,答案质量必然下降。 所以,蒸馏过程只能让“全科医生”模仿“专家委员会”的结论,却无法赋予其内在的分工协作能力。因此,两者是 架构迥异、能力代差显著的独立个体,而非同一模型的“大小版本”。

能力差距的根源:

架构差异:MoE 的动态计算分配 vs 密集模型的固定计算负载。

规模碾压:671B 参数提供的表征空间远超 7B/14B 模型。

训练深度:基座模型的全量多阶段训练 vs 蒸馏模型的轻量级微调。

硬件适配:企业级集群的优化部署 vs 本地环境的显存带宽限制。

参数是什么?

简单来说,参数可以看作模型中的“记忆单元”或“调节旋钮”,它们决定了模型如何理解和生成语言。参数越多,模型在训练过程中就能捕捉到更多的语言细节和语义关联,从而具备更强的推理和生成能力。

大语言模型的上下文窗口:

是模型在处理输入文本时,能够“记住”并参考的最大文本长度或词汇数。在自然语言处理中,上下文窗口决定了模型在生成或理解文本时,能够同时考虑的历史信息范围。

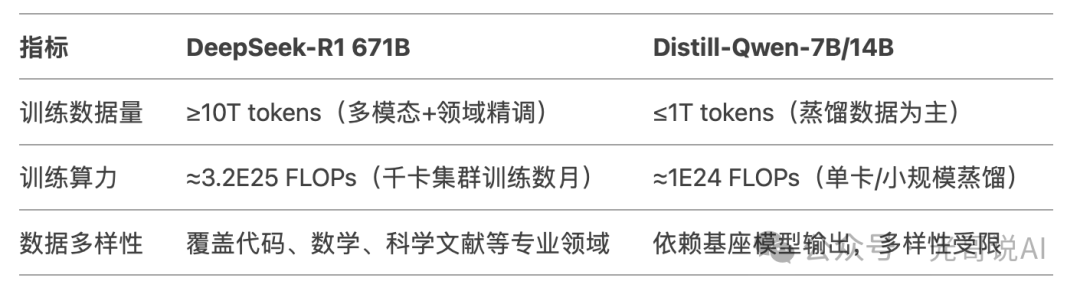

蒸馏的固有局限性,为什么蒸馏后效果打折?

信息损失:蒸馏过程无法完全保留基座模型的隐层表征多样性(尤其是 MoE 的多专家协同机制)。 说人话就是,在压缩过程中,小模型无法完整复制大模型中所有的细节和关联,因此必然会丢失一部分信息。

能力阉割:为降低计算成本,蒸馏模型常移除基座模型的辅助损失函数(如代码执行正确性验证、数学推导链监督)。说人话就是, 即使小模型能够模仿大模型的部分行为,但它有限的参数量决定了它在面对复杂场景时的表达和推理能力远不如大模型。

泛化衰减:大模型由于参数丰富,能够更好地处理各种多样化的输入,而小模型则更容易在面对未曾见过的情景时出错或产生不准确的回答

训练数据的对比:

常见误区:

误区1:部署DeepSeek-R1算力成本低?

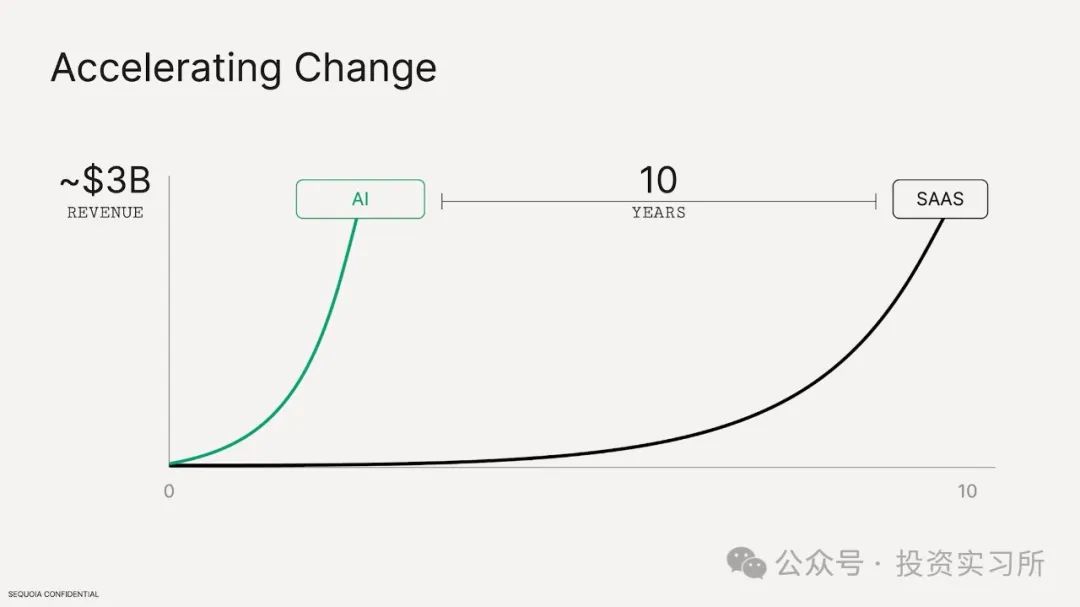

这是很多朋友的误区,市面经常讲的DeepSeek大幅降低成本,是指DeepSeek-R1 671B训练和推理成本的降低(每次推理仅调用部分个专家,计算量降至上述蒸馏模型的10%-20%)。但并不代表着蒸馏模型在推理阶段的成本降低,可能还会增加。

蒸馏模型随推理复杂度非线性增长(增加了“思考”的过程 )。32B模型处理1K Token需约200 TFLOPs(FP16)。3步反思需约600 TFLOPs,若需维持与之前非推理模型相同延迟,实际上算力需求增幅至少1.5-2倍。这些都要考虑的隐性成本。

误区 2:小模型经过微调可匹敌大模型

微调仅能优化特定任务(如分类),但无法突破参数规模限制的 表征容量天花板。

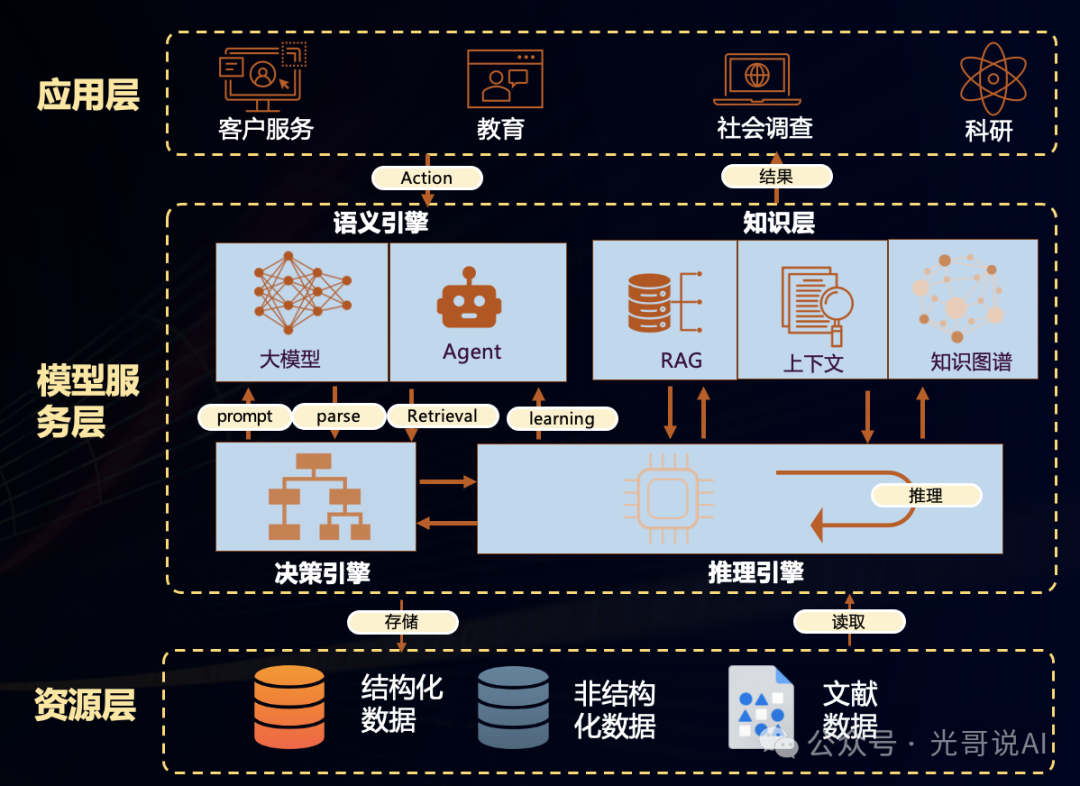

关键认知3:要在应用中真正发挥 AI 模型的价值应该怎么办?

即然么这么多问题,私有化部署的模型还能用吗?答案是:可以,但是有解决以上挑战的方案。光哥根据过往的落地的实践经验,上一些干货。

单机部署大模型,如果要发挥出价值往往要一些专业的考虑。唯有理解技术本质,结合业务需求设计和应用合理方案,才能真正让AI成为生产力革命的引擎,而非“玩具“。

对于个人用户:

认知提升:了解一些常识,避免只被宣传和表面数据所吸引。 推荐文章:拒绝智商税!使用DeepSeek不需要"独家技巧"

务实选择工具:如果目标是构建个人知识库或类似应用,可以考虑使用已经成熟的商业产品或大型模型服务,而不是仅依赖小参数模型。

技术投入:需要有一定的编程基础和数据处理能力,或者寻求相关技术支持,才能将模型与实际应用有效结合。

简单任务(如笔记整理)使用本地蒸馏模型。

复杂需求(如论文润色)调用云端API(DeepSeek-R1)。

对于企业用户:

全面评估需求:在选择部署模型之前,企业应明确自身业务场景和对模型能力的要求。对于复杂的任务,大型模型或定制化解决方案可能更适合,算好ROI。

选择专业团队合作:建设和维护一个高质量的 AI 应用,不仅需要购买或部署模型,还需要数据工程师、机器学习专家和系统架构师等多方面人才的支持。

长期规划与迭代:AI 技术更新迅速,企业应有长期投入和持续优化的准备,避免一次性投入后效果不佳或迅速被市场淘汰。

下面是一些经验供参考,如了解更多,欢迎加微信:89931668邀请你加入免费交流群,共享相关参考资料。

私有化部署小模型为何容易“翻车”?——隐藏的三大陷阱

陷阱1:硬件缩水导致的“性能骨折” 以Qwen-7B为例,其理论性能需在 GPU(40GB) 上以FP16精度运行。但一些用户在GPU 24GB 上部署,须启用4-bit量化——这相当于把高清电影压缩成240P画质:精度损失导致推理准确率下降。 显存带宽的限制也会带来吞吐量下降,无法满足实时交互需求。

陷阱2:领域适配的“隐形成本” 企业常误以为“部署即用”,实则需额外投入:要让中小参数模型适配场景,需标注数万条QA数据。 工程上要做优化,需要定制开发缓存系统,否则响应延迟导致用户体验崩塌。

陷阱3:幻觉问题的“沉默杀手” 小模型因知识密度不足,更易产生 事实性错误。

光哥案例经验:某企业部署某32B模型后,通过以下优化将问答错误率从18%降至5%:

使用 50000条领域问答数据 微调模型。 通过”安全管理智能体“ 处理高风险关键词。 通过多AI Agent智能体交互提升结果质量和企业其他的交互

智能体AI Agent:

简单来说就是AI大模型与应用、工具或服务进行交互的程序。AI Agent通过精心设计开发的程序指导AI大模型何时以及如何使用这些应用、工具或服务。

如果你们公司及产品也已经接入DeepSeek,欢迎加微信:89931668,告诉我们你们公司在AI上的创新应用,我们将请杭州电子商务研究院(eb.ac.cn)采用为典型案例,并请企通社(QitongShe.com)为您进行宣传报道。

请先 登录后发表评论 ~