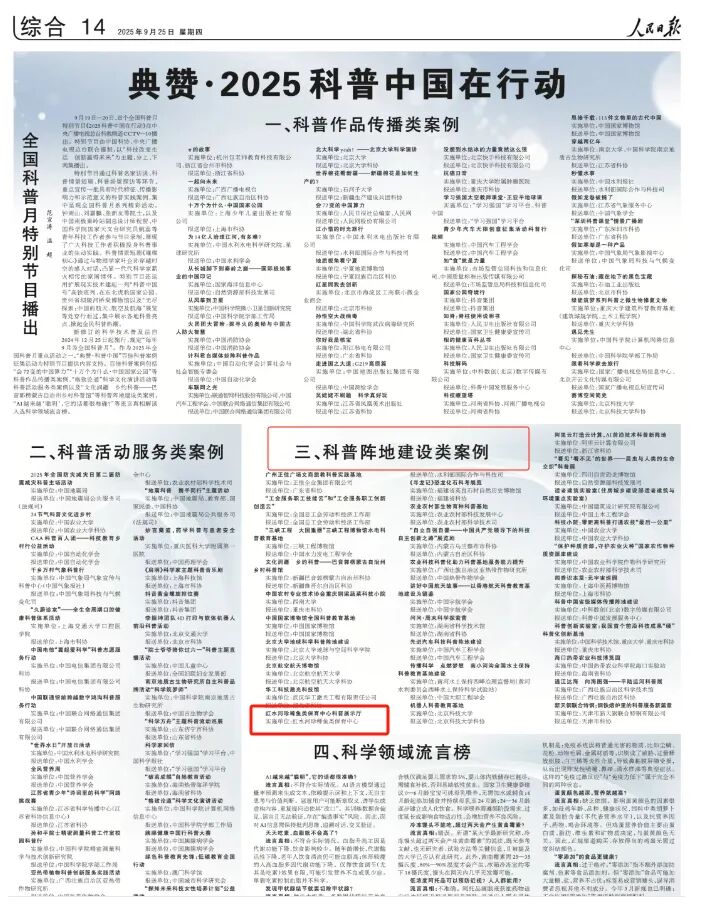

关于DeepSeek的十条谣言

关于DeepSeek的十条谣言

最近DeepSeek靠着V3和R1两个模型彻底破了圈,从美国总统到平民百姓人人都在讨论DeepSeek,而这些讨论里充斥着各种误解和谣言,本文截取了一些最离谱的误解和谣言逐一分析和澄清一遍。

一:DeepSeek宣称自己一共只花了550万美元

DeepSeek从来没说过自己训练R1模型只花了550万美元,这个误会的出处是DeepSeek V3的报告:

在预训练阶段,DeepSeek-V3模型每处理一万亿token仅需消耗18万H800 GPU小时。基于我们搭载2048张H800 GPU的集群计算,这一阶段的训练时间仅需3.7天。整个预训练阶段总计消耗266.4万GPU小时,耗时不足两个月。结合上下文长度扩展所需的11.9万GPU小时以及后期训练的0.5万GPU小时,DeepSeek-V3模型的完整训练流程总成本仅为278.8万GPU小时。若以每H800 GPU小时2美元的租赁价格计算,我们的总训练成本仅为557.6万美元。

实际上DeepSeek宣称的是V3最终版本的训练阶段只花了2048个H800一共1315个小时,如果按照H800 2刀一小时的租金的话,总计需要557.6万美元。这是一个学术Paper比较标准的内容,是为了证明V3的训练成本大概是同级别的模型的十分之一。

这五百多万显然不包含人才薪资、购买的硬件、前期实验、数据准备等等各种成本,结果中美的记者、大V和网友们却误以为DeepSeek说自己从创建开始一共只花了五百万美元,还为这事吵的不可开交,还有人去计算幻方从成立开始一共花了多少钱来“辟谣”,让人啼笑皆非。

二:DeepSeek有五万张H100

这条谣言出自Scale AI的创始人亚历山大·王的一次采访,然后马斯克在X上评论说”很显然是“。

这谣言显然是”利益相关“和”大内宣”,因为Scale AI的业务就是标注数据,DeepSeek R1证明了标注数据没那么有用,而马斯克的xAI是真的买了几万张H100,却毛都没训出来,还不如直接甩锅给拜登政府管控不力,一举两得。实际上,幻方在招人时经常炫耀自己的GPU多,但真实的数字大概就在1万多张,而且主力还是A100和H800。五万张H100纯属子虚乌有。

三:DeepSeek是OpenAI的套壳

DeepSeek V3回答时经常误认为自己的是OpenAI的GPT系列模型,然后被不懂行的网友拿来作为DeepSeek是套壳的佐证。DeepSeek显然不是套壳gpt,最直接的证据就是DeepSeek是开源的而OpenAI是闭源的,不信的人可以自己买一套H800部署一套或者用国外fireworks/together.ai平台自己部署的开源版本。而R1出来之后这个谣言也可以不攻自破了,因为R1的说话风格和o1差别太大了,绝对不可能套壳,具体可以看看我之前的分享。

DeepSeek认为自己是OpenAI GPT的原因可能是两点:1. 模型训练的数据来自互联网,而GPT生成的内容已经污染了互联网的语料。 2. DeepSeek是用gpt来合成部分训练数据,这部分恰好包含了很多关于gpt身份认知的信息。而DeepSeek团队后训练又做的很随意,对于这件事也并不是很在乎,所以才出现DeepSeek误认为自己是OpenAI的回答。

四:DeepSeek R1完全是蒸馏/照抄的OpenAI o1

蒸馏这条评论还是有一定真实性在里面的,但不太准确。DeepSeek V3在训练过程中大概率用gpt合成了一部分数据(这也是今天OpenAI和微软宣称调查DeepSeek的原因),但R1绝对不是蒸馏的o1,因为o1根本不返回思维链过程,而且R1的paper中也详细解释了其训练过程,除了冷启动阶段需要几千条外,根本不需要太多思维链数据,思维链能力是RL训练中涌现出来的。

另外一个谣言是“OpenAI o1的训练方法是公开的,DeepSeek只需要照抄就行”。然而OpenAI的技术是完全封闭的,之前大家猜测o1的RL方法也是以PRM和MCTS为主,DeepSeek用的ORM是靠自己的实验证明有效的,OpenAI的研究员也在X上同意DeepSeek独立发现了可行的RL方法。

五:DeepSeek是个小模型,可以在个人电脑跑起来

看到很多《本地运行DeepSeek R1》的教程,一些美股评论员也说DeepSeek是小模型+小数据的胜利。这是完全错误的,首先DeepSeek V3/R1模型本身是671B的超大模型,是开源模型里最大的之一,而且也用了14T的数据训练,绝对算不上”小数据“。

而本地电脑能跑的7B到72B的模型实际是用DeepSeek R1微调出来的Qwen和Llama模型,是DeepSeek团队为了验证蒸馏的效果做的。很多人本地跑了这些蒸馏模型,发现效果不好,然后误以为是DeepSeek R1模型不好。这些本地模型不是DeepSeek R1,这些蒸馏模型的”智商“是受到原本基座模型的限制的,R1只是教会了它们思考,所以效果一定是远不如R1的。

六:DeepSeek是幻方这几个月包装出来割韭菜的

最近也看到一些质疑DeepSeek的言论说一个从来没听过的公司忽然这么牛逼,一定是幻方花了大笔营销费用包装出来割股民韭菜的。还有人拿着DeepSeek公司工商信息里参保人数只有4个人说他们是皮包公司。实际上DeepSeek在2023年年中就开始了大模型研究,且一直在开源模型中处于领先地位,在圈子里一直以技术创新闻名,包括国内的第一个MoE模型DeepSeek-MoE,DeepSeek V2打响大模型价格战,国内的第一个推理模型R1-Lite等等,只是最近的V3和R1才破圈而已。

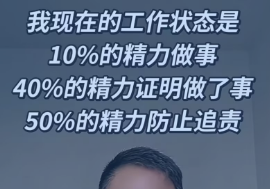

七:DeepSeek是幻方的业余项目

这个更多是网友的玩梗被信以为真了,实际上相比于量化,DeepSeek更像是幻方的主营业务了,起码对于梁文锋来说是这样:一是梁总在大模型业务上亲力亲为,一直和DeepSeek团队一起呆在北京办公室,二是内部量化团队有在抱怨梁总不管量化业务,导致自营盘子赚的钱不如往年。

还有说幻方靠做空英伟达赚钱,其实这次火出圈和导致美股暴跌对DeepSeek团队来说也是意外,他们的风格一直是模型训着训着发现差不多了就发出来,其实V3后训练也做得很随意,主要是为了展示训练效率上的学术成果,估计他们自己也没有想到竟然火出圈了。

八:DeepSeek产品不好用,所以模型很垃圾

很多人因为DeepSeek APP拒绝回答、回答很慢、识图不准、信息滞后等等原因认为DeepSeek模型能力很差。实际上上面的这些问题都不是模型能力的问题,比如识图不准是因为多模态只是通过OCR而不是模型,System Prompt没有给出当前日期等等。其实是因为DeepSeek产品做的比较敷衍,毕竟APP只是为了给懂行的人展示自己模型能力,DeepSeek唯一的目标就是AGI,而不是通过服务用户而盈利。想用好产品的人建议去用豆包,虽然字节的模型能力不是最牛逼的,但是论产品体验没人比得过豆包。

九:DeepSeek是国内第一个顶级模型

很多人以为中国AI之前一直落后美国很多年,DeepSeek忽然凭空就追上来了,实际上中国的大模型一直处于第一梯队,尤其是开源领域:阿里巴巴的千问Qwen系列一直是开源模型的并列第一,它的14B和32B模型一直是本地部署模型的首选,MiniMax前几天开源的01模型是世界上最大的线性注意力模型,还有像MiniCPM、RWKV这样的精品端侧小模型等等。

还有在多模态领域,视频生成有快手的可灵(比Sora早半年发布)和MiniMax的海螺,语音有字节的端到端语音模型,实际上即使没有DeepSeek,中美AI的差距一直在几个月之内,在某些细分领域我们还是领先的,完全没有一些人说的五到十年那么夸张。

十:DeepSeek已经吊打OpenAI了

这条就属于吹的有点过头了,实际上DeepSeek做到的是通过局部创新,以极低的成本实现接近OpenAI顶级模型的水平,不论是FP8、MLA还是MTP、ORM都更类似于“术”的创新而非“道”的创新,目前0到1的范式的创新还是由OpenAI去引导的,这不是中美之间的差距而是OpenAI与其他公司的差距,美国的Google、Meta、Anthropic目前也是在追着OpenAI的脚步。不过随着技术差距逐渐被拉平,凭借着后发优势和人才储备,中国团队将有希望引领下一波AI的范式创新。

请先 登录后发表评论 ~